記事の概要

ソフトバンクとAmpereは、2023年2月17日にCPUを使ったAI推論の効率化に関する共同検証を開始したことを発表しました。

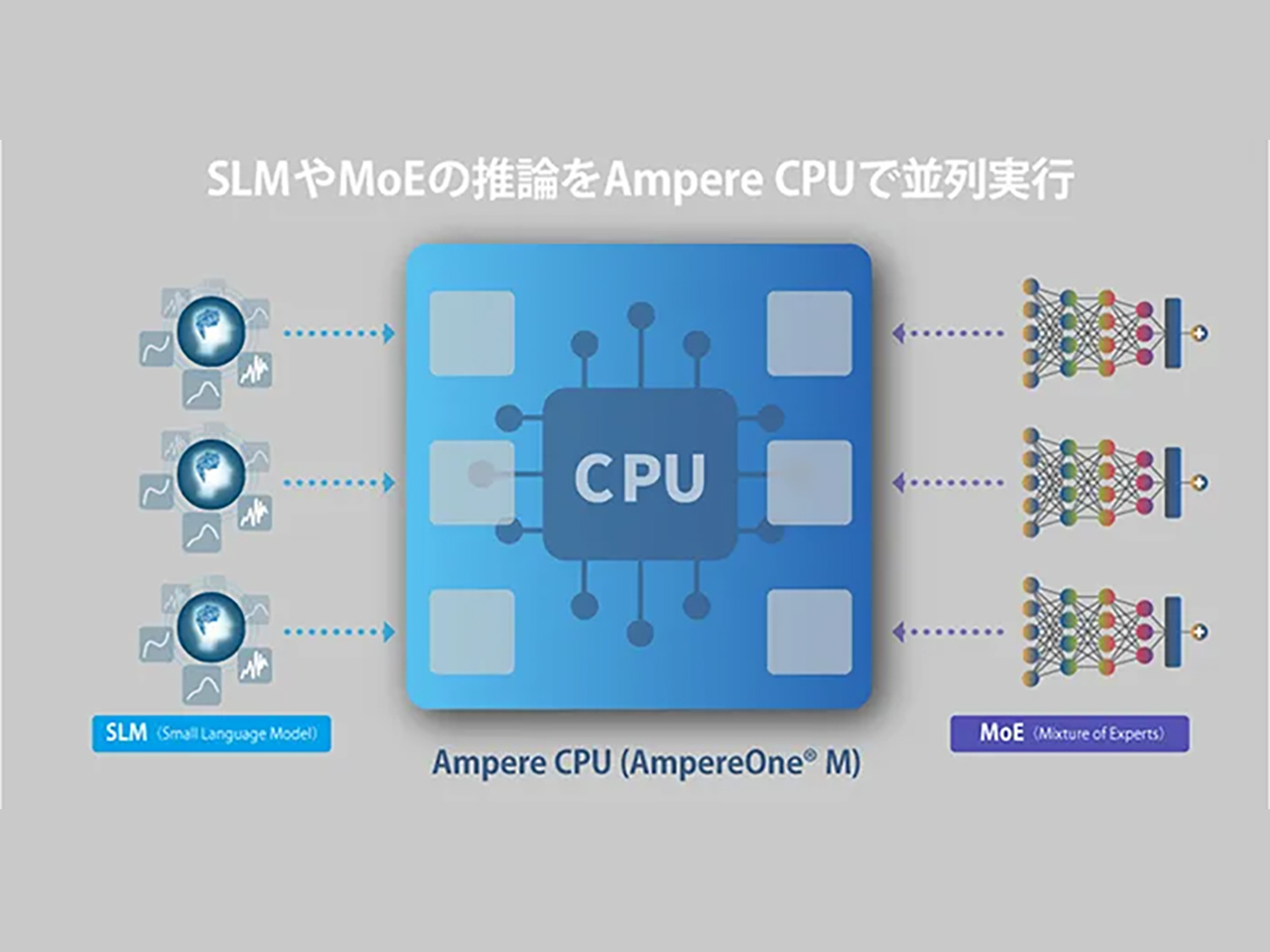

AIエージェント時代を見据え、小規模AIモデルをCPUで分散運用することで計算資源の効率を向上させる狙いがあります。

特に、低遅延・高効率な推論が求められる分野において、GPU中心の構成ではコストや消費電力の問題があるため、CPUの活用が注目されています。

検証では、ソフトバンクのAIモデル配分オーケストレーターを用いて、CPUのみやCPUとGPUを組み合わせたノードでの柔軟なモデル配置が確認されました。

また、Ampere製CPU向けに最適化されたオープンソースのAI推論フレームワークにより、消費電力を抑えつつ同時実行数を増やし、高速なモデル切り替えが可能であることが示されました。

今後は、安定したAI推論プラットフォームの実現に向けて取り組みを続ける予定です。

記事のポイント

詳しい記事の内容はこちらから(引用元)

ソフトバンクとAmpereは、CPUを使ったAI推論の効率化に関する共同検証を開始すると発表した。AIエージェント時代に…

https://japan.zdnet.com/article/35243983/